事前のデータ整備は軽視されがちである

Web解析の領域で、事前のデータ整備は軽視されがちです。「トラフィック量が大きくなると、こういうことが起きるだろう」という想定の元に、事前の設定や導入の見直しが検討されることはまずありません。

データ分析の領域では、データ統合の際などにデータの前処理としてETLが用いられますが、ローデータがあるからこそ後からでもデータ整備を行えます。

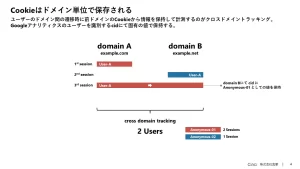

一方で、例えばGoogleアナリティクスのUIやAPIから扱えるデータは、ビジネスインテリジェンスとしてはいったん既に処理されたデータです。「混在したデータ、勝手に集約されたデータは、どうしようもない」ということになってしまいます。

一般には、事前に以下のような対応をしておくと良いと考えます。

- データの集約

- データの区別

- 取得すべきデータの取得

- ゴミの除去

- ツールの仕様を踏まえた取得

Googleアナリティクスも同様です。集約すべきデータは集約し、区別するものは区別し、ゴミは取り除く、というのが基本です。合わせて、計測目的を前提としてツールの仕様も理解し、それに沿った計測設定を施さなければいけません。

しかし残念ながら、多くのGoogleアナリティクスではそういう視点で運用されていません。事前の設定はほとんどなされていません。

そのあたりをなんとかしたいと、ずっと思っています。

去る11月7日、「中規模サイトのためのGoogleアナリティクス導入設定」というセミナー講座を開催しました。4時間半の長丁場の講座で、アンケートでも高評価でした。以前にも企業向けにクローズドで実施した内容です。ご希望いただけたらまた開催するかもしれません。